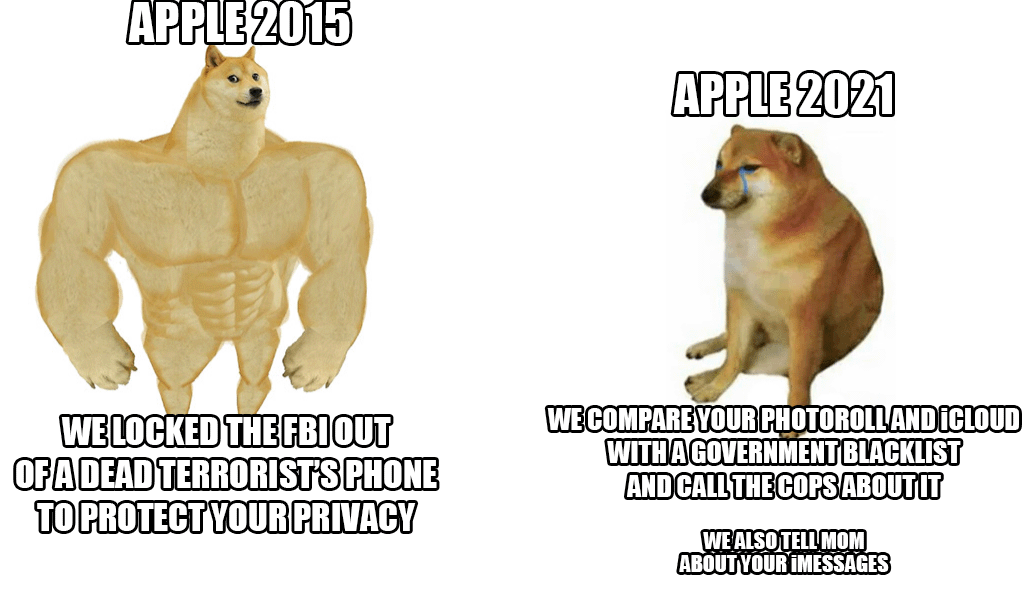

A finals de la setmana passada, Apple va presentar un nou sistema contra l'abús infantil que escanejarà pràcticament les fotos d'iCloud de tothom. Tot i que la idea sona bé a primer cop d'ull, ja que realment cal protegir els nens d'aquesta acció, el gegant de Cupertino va ser criticat per una allau, no només per part dels usuaris i experts en seguretat, sinó també de les files dels mateixos empleats.

Segons l'última informació d'una agència respectada Reuters diversos empleats van expressar la seva preocupació per aquest sistema en una comunicació interna a Slack. Suposadament, haurien de tenir por dels possibles abusos per part d'autoritats i governs, que podrien abusar d'aquestes possibilitats, per exemple, per censurar persones o grups seleccionats. La revelació del sistema va provocar un fort debat, que ja compta amb més de 800 missatges individuals dins de l'esmentat Slack. En resum, els empleats estan preocupats. Fins i tot els experts en seguretat han cridat l'atenció anteriorment sobre el fet que en mans equivocades seria una arma realment perillosa utilitzada per suprimir els activistes, la seva esmentada censura i similars.

La bona notícia (fins ara) és que la novetat només començarà als Estats Units. De moment, ni tan sols està clar si el sistema també s'utilitzarà dins dels estats de la Unió Europea. No obstant això, malgrat totes les crítiques, Apple es manté per si mateixa i defensa el sistema. Argumenta sobretot que tota la comprovació es fa dins del dispositiu i un cop hi ha una coincidència, només en aquest moment el cas és revisat de nou per un empleat d'Apple. Només a la seva discreció es lliurarà a les autoritats competents.

Podria ser t'interessa

No m'agradaria canviar d'iCloud a una cosa segura i realment privada, però si Apple insisteix, deixaré de pagar-los de totes maneres.

Estarà actiu (de moment) només als EUA

Realment no importa on s'aplicarà legislativament. Aquesta tecnologia ja estarà disponible i desplegada. Aquest és el risc més gran.